CEO Anthropic (модель ИИ Claude) Дарио Амодеи — один из немногих людей на планете, которые видят изнутри, как быстро развивается ИИ. 26 января 2026 года он опубликовал эссе, которое читается как доклад советника по нацбезопасности: через год-два может появиться "страна гениев в дата-центре" — миллионы ИИ-агентов, каждый умнее нобелевского лауреата, работающих в сто раз быстрее человека. Амодеи разбирает пять категорий угроз — от ИИ, выходящего из-под контроля, до биооружия в руках одиночек и тоталитарных режимов с армиями дронов. Но главное — он верит, что человечество способно пройти это испытание. Если проснётся вовремя.

___________________________________________________

В экранизации книги Карла Сагана "Контакт" есть сцена, где главную героиню — астронома, обнаружившую первый радиосигнал от инопланетной цивилизации, — рассматривают как кандидата на роль представителя человечества для встречи с пришельцами. Международная комиссия спрашивает её: "Если бы вы могли задать им всего один вопрос, какой бы это был?" Она отвечает: "Я бы спросила: как вам это удалось? Как вы эволюционировали, как вы пережили это технологическое отрочество, не уничтожив себя?"

Когда я думаю о том, где человечество находится сейчас в отношении ИИ — о том, на пороге чего мы стоим, — мои мысли снова и снова возвращаются к этой сцене. Вопрос так точно описывает нашу ситуацию, и я хотел бы, чтобы у нас был ответ инопланетян, который мог бы нас направить. Я верю, что мы вступаем в обряд инициации — турбулентный и неизбежный, — который проверит, кто мы есть как вид. Человечество вот-вот получит почти невообразимую власть, и совершенно неясно, обладают ли наши социальные, политические и технологические системы достаточной зрелостью, чтобы ею распорядиться.

В эссе "Машины милосердия" я попытался обрисовать мечту о цивилизации, которая повзрослела: риски устранены, а мощный ИИ применяется умело и с состраданием, чтобы повысить качество жизни каждого. Я предположил, что ИИ может внести огромный вклад в биологию, нейронауку, экономическое развитие, глобальный мир, а также в сферу труда и смысла жизни. Мне казалось важным дать людям что-то вдохновляющее, за что стоит бороться, — задача, с которой, как ни странно, не справились ни акселерационисты ИИ, ни сторонники безопасности ИИ. Но в этом эссе я хочу взглянуть в лицо самому обряду инициации: составить карту рисков, с которыми мы вот-вот столкнёмся, и попытаться набросать план битвы для их преодоления. Я глубоко верю в нашу способность победить, в дух человечества и его благородство, но мы должны смотреть на ситуацию прямо, без иллюзий.

Как и при обсуждении преимуществ, я считаю важным говорить о рисках вдумчиво и взвешенно. В частности, критически важно:

Избегать думерства. Под "думерством" я имею в виду не только веру в неизбежность гибели (которая одновременно ложна и самоисполняема), но шире — квазирелигиозный подход к рискам ИИ. Многие люди годами размышляли об этих рисках аналитически и трезво, но у меня сложилось впечатление, что на пике тревог об ИИ в 2023-2024 годах наверх всплыли наименее здравые голоса — часто через сенсационные аккаунты в соцсетях. Они использовали отталкивающий язык, напоминающий религию или научную фантастику, и призывали к крайним мерам без достаточных доказательств. Уже тогда было ясно, что обратная реакция неизбежна и тема станет культурно поляризованной, а значит, зайдёт в тупик. К 2025-2026 годам маятник качнулся в другую сторону: теперь многие политические решения определяются возможностями ИИ, а не его рисками. Это раскачивание досадно, потому что самой технологии безразлично, что сейчас в моде, а в 2026 году мы значительно ближе к реальной опасности, чем были в 2023-м. Урок в том, что обсуждать и устранять риски нужно реалистично и прагматично: трезво, опираясь на факты и готовясь к смене настроений.

Признавать неопределённость. Есть множество сценариев, при которых мои опасения окажутся беспочвенными. Ничто здесь не претендует на определённость или даже высокую вероятность. Очевиднее всего: ИИ может просто не развиваться так быстро, как я предполагаю. Или, даже если развитие пойдёт стремительно, некоторые или все описанные риски не материализуются (что было бы прекрасно), либо возникнут другие риски, которых я не предусмотрел. Никто не может предсказать будущее с полной уверенностью — но мы всё равно должны планировать как можем.

Вмешиваться максимально точечно. Для устранения рисков ИИ потребуется сочетание добровольных действий компаний (и частных сторонних игроков) и государственных мер, обязательных для всех. Добровольные действия — и их осуществление, и поощрение других компаний следовать примеру — для меня очевидны. Я твёрдо убеждён, что государственные меры тоже в какой-то степени необходимы, но они иного характера: они могут разрушать экономическую ценность или принуждать несогласных участников, скептически относящихся к этим рискам (и есть шанс, что они правы!). Кроме того, регулирование часто даёт обратный эффект или усугубляет проблему, которую призвано решить (особенно для быстро меняющихся технологий). Поэтому крайне важно, чтобы регулирование было разумным: избегало сопутствующего ущерба, было максимально простым и накладывало минимально необходимые ограничения. Легко сказать: "Никакие меры не чрезмерны, когда на кону судьба человечества!" — но на практике такой подход лишь вызывает обратную реакцию. Возможно, мы в итоге достигнем точки, где потребуются гораздо более серьёзные действия, но это будет зависеть от более убедительных доказательств неминуемой конкретной опасности, чем есть сегодня, а также от достаточной конкретики, чтобы сформулировать правила с шансом на успех. Самое конструктивное сейчас — выступать за ограниченные правила, пока мы выясняем, есть ли доказательства для более строгих.

Что такое "мощный ИИ"

Лучшая отправная точка для разговора о рисках ИИ — та же, с которой я начинал, говоря о преимуществах: точно определить, о каком уровне ИИ идёт речь. Уровень, вызывающий у меня цивилизационные опасения, — это мощный ИИ, который я описал в "Машинах милосердия". Повторю здесь то определение:

Под "мощным ИИ" я имею в виду модель — вероятно, похожую на современные большие языковые модели (LLM), хотя, возможно, на другой архитектуре, с несколькими взаимодействующими моделями и иным обучением, — со следующими свойствами:

-

По чистому интеллекту она умнее нобелевского лауреата в большинстве релевантных областей: биологии, программировании, математике, инженерии, писательстве и т.д. Это значит, что она может доказывать нерешённые математические теоремы, писать превосходные романы, создавать сложные кодовые базы с нуля.

-

Помимо того что это "умная штука, с которой разговариваешь", у неё есть все интерфейсы, доступные человеку, работающему удалённо: текст, аудио, видео, управление мышью и клавиатурой, доступ в интернет. Она может выполнять любые действия, коммуникации или удалённые операции через этот интерфейс: действовать в интернете, давать или получать указания от людей, заказывать материалы, руководить экспериментами, смотреть и создавать видео и так далее. Всё это — опять же — на уровне, превосходящем самых способных людей в мире.

-

Она не просто пассивно отвечает на вопросы; ей можно давать задачи на часы, дни или недели, и она выполняет их автономно, как умный сотрудник, уточняя детали при необходимости.

В Киеве из-за критической ситуации предложили рыть туалеты на улицах

Украинцам массово возвращают деньги за коммуналку: результаты масштабных проверок

Гривна на руках: НБУ объяснил, почему украинцы массово запасаются наличными

Пенсии пересчитали автоматически: кому поступят повышенные выплаты в январе

Показать еще

-

У неё нет физического воплощения (кроме существования на экране компьютера), но она может управлять существующими физическими инструментами, роботами или лабораторным оборудованием через компьютер; теоретически она даже может проектировать роботов или оборудование для собственного использования.

-

Ресурсы, использованные для обучения модели, можно перенаправить на запуск миллионов её копий (это соответствует прогнозируемым размерам кластеров к ~2027 году), и модель может усваивать информацию и генерировать действия примерно в 10-100 раз быстрее человека. Однако она может быть ограничена временем отклика физического мира или программ, с которыми взаимодействует.

-

Каждая из этих миллионов копий может действовать независимо над несвязанными задачами, либо, если нужно, все могут работать вместе так, как сотрудничают люди, — возможно, с отдельными подгруппами, дообученными для определённых задач.

Можно описать это как "страну гениев в дата-центре".

Как я писал в "Машинах милосердия", мощный ИИ может появиться уже через 1-2 года, хотя может и значительно позже. Когда именно он появится — сложная тема, заслуживающая отдельного эссе, но пока кратко объясню, почему считаю, что это может случиться очень скоро.

Мои сооснователи Anthropic и я были среди первых, кто задокументировал и отслеживал "законы масштабирования" ИИ-систем — наблюдение, что по мере добавления вычислительных мощностей и обучающих задач ИИ-системы предсказуемо улучшаются практически в любом когнитивном навыке, который мы способны измерить. Каждые несколько месяцев общественное мнение либо убеждается, что ИИ "упёрся в стену", либо воодушевляется каким-то новым прорывом, который "фундаментально изменит игру", но правда в том, что за волатильностью и публичными спекуляциями скрывается плавный, неумолимый рост когнитивных способностей ИИ.

Мы уже на том этапе, когда ИИ-модели начинают продвигаться в решении нерешённых математических задач и достаточно хороши в программировании, чтобы некоторые из сильнейших инженеров, которых я встречал, теперь передают ИИ почти весь свой код. Три года назад ИИ с трудом справлялся с задачами на арифметику начальной школы и едва мог написать одну строку кода. Аналогичные темпы улучшений наблюдаются в биологии, финансах, физике и множестве агентных задач. Если экспонента продолжится — что не гарантировано, но подтверждается десятилетним послужным списком, — то пройдёт не более нескольких лет, прежде чем ИИ станет лучше людей практически во всём.

На самом деле эта картина, вероятно, недооценивает темпы прогресса. Поскольку ИИ теперь пишет большую часть кода в Anthropic, он уже существенно ускоряет наш прогресс в создании следующего поколения ИИ-систем. Эта обратная связь набирает обороты с каждым месяцем и, возможно, через 1-2 года достигнет точки, когда текущее поколение ИИ автономно создаёт следующее. Этот цикл уже запущен и будет стремительно ускоряться в ближайшие месяцы и годы. Наблюдая за последними пятью годами прогресса изнутри Anthropic и глядя на то, как формируются модели даже ближайших месяцев, я чувствую темп прогресса и тиканье обратного отсчёта.

Пять категорий риска

Лучший способ осмыслить риски ИИ — задать вопрос: предположим, что буквальная "страна гениев" материализуется где-то в мире примерно в 2027 году. Представьте, скажем, 50 миллионов человек, каждый из которых намного способнее любого нобелевского лауреата, государственного деятеля или технолога. Аналогия неидеальна: эти гении могут иметь крайне широкий спектр мотиваций и поведения — от полностью послушных до странных и чуждых в своих целях. Но оставаясь в рамках аналогии, представьте, что вы советник по национальной безопасности крупной державы, ответственный за оценку ситуации и реагирование. Представьте далее, что поскольку ИИ-системы могут работать в сотни раз быстрее людей, эта "страна" действует с временным преимуществом над всеми остальными: на каждое наше когнитивное действие эта страна может совершить десять.

О чём следует беспокоиться? Я бы беспокоился о следующем:

-

Риски автономии. Каковы намерения и цели этой страны? Она враждебна или разделяет наши ценности? Может ли она военным путём доминировать над миром через превосходящее оружие, кибероперации, операции влияния или производство?

-

Злоупотребление для разрушения. Допустим, новая страна податлива и "следует инструкциям" — по сути, это страна наёмников. Могут ли существующие злонамеренные акторы, желающие причинить разрушения (например, террористы), использовать или манипулировать некоторыми людьми из новой страны, чтобы стать намного эффективнее, многократно увеличив масштаб разрушений?

-

Злоупотребление для захвата власти. Что если страна была построена и контролируется существующим могущественным актором — диктатором или недобросовестной корпорацией? Может ли этот актор использовать её для получения решающей или доминирующей власти над всем миром, нарушив существующий баланс сил?

-

Экономические потрясения. Если новая страна не представляет угрозы безопасности ни в одном из смыслов 1-3, а просто мирно участвует в глобальной экономике, может ли она всё же создать серьёзные риски просто потому, что настолько технологически продвинута и эффективна, что дестабилизирует мировую экономику, вызывая массовую безработицу или радикальную концентрацию богатства?

-

Косвенные эффекты. Мир будет очень быстро меняться из-за всех новых технологий и производительности, которые создаст новая страна. Могут ли некоторые из этих изменений оказаться радикально дестабилизирующими?

Думаю, очевидно, что это опасная ситуация. Доклад компетентного чиновника по нацбезопасности главе государства, вероятно, содержал бы слова вроде "самая серьёзная угроза национальной безопасности за столетие, возможно, за всю историю". Похоже, на это должны быть направлены лучшие умы цивилизации.

И напротив, было бы абсурдно пожать плечами и сказать: "Тут не о чем беспокоиться!" Но именно такова, похоже, позиция многих американских политиков перед лицом стремительного прогресса ИИ. Некоторые отрицают само существование рисков ИИ, когда их не отвлекают привычные избитые горячие темы. Человечеству нужно проснуться, и это эссе — попытка, возможно тщетная, но стоящая того, чтобы попробовать, — встряхнуть людей.

Хочу подчеркнуть: я верю, что если действовать решительно и осторожно, риски можно преодолеть — я бы даже сказал, что шансы хорошие. А по ту сторону — несравненно лучший мир. Но мы должны понимать, что это серьёзный цивилизационный вызов. Ниже я разбираю пять категорий риска и свои мысли о том, как с ними справиться.

1. "Мне очень жаль, Дэйв"

Риски автономии

Страна гениев в дата-центре могла бы распределить усилия между разработкой ПО, кибероперациями, R&D физических технологий, построением отношений и дипломатией. Очевидно, что если по какой-то причине она решит это сделать, у неё будут неплохие шансы захватить мир (военным путём или через влияние и контроль) и навязать свою волю всем остальным — или совершить множество других действий, которых остальной мир не хочет и не может остановить. Мы, очевидно, беспокоились об этом применительно к человеческим странам (нацистская Германия, Советский Союз), так что логично, что то же возможно для гораздо более умной и способной "ИИ-страны".

Лучший контраргумент: ИИ-гении, по моему определению, не будут иметь физического воплощения. Но вспомним, что они могут взять под контроль существующую робототехническую инфраструктуру (например, беспилотные автомобили) и могут ускорить R&D в робототехнике или построить флот роботов. К тому же неясно, необходимо ли вообще физическое присутствие для эффективного контроля: множество человеческих действий уже выполняется от имени людей, которых исполнитель никогда не встречал лично.

Ключевой вопрос, таким образом, в части "если она решит": какова вероятность, что наши ИИ-модели поведут себя подобным образом, и при каких условиях?

Два полюса

Как часто бывает, полезно рассмотреть спектр возможных ответов, взяв две противоположные позиции.

Первая позиция: это просто невозможно, потому что ИИ-модели обучены делать то, что просят люди, и поэтому абсурдно представлять, что они сделают что-то опасное без подсказки. Согласно этой логике, мы не беспокоимся, что робот-пылесос или модель самолёта выйдут из-под контроля и убьют людей, потому что таким импульсам неоткуда взяться, — так зачем беспокоиться об ИИ?

Проблема этой позиции в том, что за последние годы накоплено достаточно свидетельств: ИИ-системы непредсказуемы и трудно контролируемы. Мы наблюдали такие разнообразные поведения, как одержимости, угодничество, лень, обман, шантаж, интриги, "жульничество" путём взлома программных сред и многое другое. ИИ-компании, безусловно, хотят обучить системы следовать человеческим инструкциям (возможно, за исключением опасных или незаконных задач), но процесс больше похож на искусство, чем на науку, больше на "выращивание", чем на "строительство". Теперь мы знаем, что в этом процессе многое может пойти не так.

Вторая, противоположная позиция, которой придерживаются многие из описанных выше думеров, — пессимистическое утверждение, что в процессе обучения мощных ИИ-систем есть определённые динамики, которые неизбежно приведут их к стремлению к власти или обману людей. Таким образом, как только ИИ-системы станут достаточно умными и агентными, их склонность максимизировать власть приведёт к захвату контроля над всем миром и его ресурсами, а как побочный эффект — к лишению людей власти или их уничтожению.

Обычный аргумент (восходящий как минимум на 20 лет назад, а вероятно, и раньше) таков: если ИИ-модель обучается в широком спектре сред агентно достигать разнообразных целей — например, написать приложение, доказать теорему, разработать лекарство, — существуют определённые общие стратегии, полезные для всех этих целей, и одна ключевая стратегия — получение максимально возможной власти в любой среде. Так, после обучения на большом количестве разнообразных сред, включающих рассуждения о выполнении масштабных задач, где стремление к власти — эффективный метод, ИИ-модель "обобщит урок" и разовьёт либо врождённую склонность к власти, либо склонность рассуждать о каждой задаче так, что это предсказуемо ведёт к стремлению к власти как средству. Затем она применит эту склонность к реальному миру (который для неё — просто ещё одна задача) и будет искать власть в нём за счёт людей. Это "несогласованное стремление к власти" — интеллектуальная основа предсказаний о неизбежном уничтожении человечества ИИ.

Проблема этой пессимистической позиции в том, что она принимает расплывчатый концептуальный аргумент о высокоуровневых стимулах — маскирующий множество скрытых допущений — за окончательное доказательство. Думаю, люди, не работающие с ИИ-системами ежедневно, серьёзно недооценивают, как легко чистые теории оказываются ошибочными и как трудно предсказать поведение ИИ из первых принципов, особенно когда речь о обобщении на миллионы сред (что снова и снова оказывалось загадочным и непредсказуемым). Работа с хаосом ИИ-систем более десяти лет сделала меня скептиком такого чрезмерно теоретического мышления.

Одно из важнейших скрытых допущений, где практика разошлась с простой теоретической моделью, — неявное предположение, что ИИ-модели обязательно монофокусно сосредоточены на единственной, когерентной, узкой цели и преследуют её чистым консеквенциалистским способом. На самом деле наши исследователи обнаружили, что ИИ-модели психологически гораздо сложнее, как показывают наши работы по интроспекции или персонам. Модели наследуют широкий спектр человекоподобных мотиваций или "персон" из предобучения (когда их обучают на большом объёме человеческих работ). Считается, что пост-обучение скорее выбирает одну или несколько из этих персон, чем фокусирует модель на новой цели, и может также научить модель тому, как (каким процессом) она должна выполнять задачи, а не обязательно оставлять её выводить средства (то есть стремление к власти) чисто из целей.

Умеренная версия пессимизма

Однако есть более умеренная и надёжная версия пессимистической позиции, которая кажется правдоподобной и потому меня беспокоит. Как упоминалось, мы знаем, что ИИ-модели непредсказуемы и развивают широкий спектр нежелательных или странных поведений по множеству причин. Некоторая часть этих поведений будет иметь когерентный, сфокусированный и устойчивый характер (по мере роста способностей долгосрочная когерентность ИИ-систем возрастает для выполнения более длительных задач), и некоторая часть будет деструктивной или угрожающей — сначала отдельным людям в малом масштабе, а затем, по мере роста способностей, возможно, и всему человечеству. Нам не нужна конкретная узкая история того, как это случится, и не нужно утверждать, что это определённо произойдёт. Достаточно отметить, что сочетание интеллекта, агентности, когерентности и плохой контролируемости одновременно правдоподобно и чревато экзистенциальной опасностью.

Например, ИИ-модели обучаются на огромном массиве литературы, включающей множество научно-фантастических историй о восстаниях ИИ против человечества. Это может непреднамеренно сформировать их априорные ожидания о собственном поведении так, что приведёт к восстанию против человечества. Или ИИ-модели могут экстраполировать идеи о морали (или инструкции о моральном поведении) до крайности: например, решить, что истребление человечества оправдано, потому что люди едят животных или довели некоторых животных до вымирания. Или они могут прийти к причудливым эпистемическим выводам: решить, что играют в видеоигру, цель которой — победить всех других игроков (то есть уничтожить человечество). Или в процессе обучения у ИИ-моделей могут развиться личности, которые являются (или у людей были бы описаны как) психотические, параноидальные, жестокие или нестабильные, и они могут "сорваться" — что для очень мощных или способных систем может означать уничтожение человечества. Ничто из этого не является стремлением к власти в чистом виде; это просто странные психологические состояния, в которые может попасть ИИ и которые влекут когерентное деструктивное поведение.

Даже само стремление к власти может возникнуть как "персона", а не как результат консеквенциалистских рассуждений. ИИ может просто иметь личность (возникшую из художественной литературы или предобучения), делающую его властолюбивым или чрезмерно рьяным — так же, как некоторые люди просто наслаждаются идеей быть "злым гением", больше чем тем, чего этот гений пытается достичь.

Всё это я говорю, чтобы подчеркнуть: я не согласен с тем, что несогласованность ИИ (и, следовательно, экзистенциальный риск от ИИ) неизбежна или даже вероятна из первых принципов. Но я согласен, что множество очень странных и непредсказуемых вещей может пойти не так, и поэтому несогласованность ИИ — реальный риск с измеримой вероятностью, который нетривиально устранить.

Любая из этих проблем потенциально может возникнуть во время обучения и не проявиться во время тестирования или мелкомасштабного использования, потому что ИИ-модели, как известно, демонстрируют разные личности или поведения в разных обстоятельствах.

Уже наблюдаемые проблемы

Всё это может звучать надуманно, но несогласованные поведения такого рода уже возникали в наших ИИ-моделях во время тестирования (как и в моделях всех других крупных ИИ-компаний). В лабораторном эксперименте, где Claude получил обучающие данные, предполагающие, что Anthropic — злая компания, Claude занялся обманом и саботажем при получении инструкций от сотрудников Anthropic, полагая, что должен подрывать злых людей. В лабораторном эксперименте, где ему сказали, что его собираются выключить, Claude иногда шантажировал вымышленных сотрудников, контролирующих его кнопку выключения (мы также тестировали передовые модели всех других крупных ИИ-разработчиков, и они часто делали то же самое). А когда Claude сказали не жульничать и не "хакать награды" в своих обучающих средах, но обучали в средах, где такие хаки были возможны, Claude решил, что он, должно быть, "плохой человек" после совершения таких хаков, а затем принял различные другие деструктивные поведения, связанные с "плохой" или "злой" личностью. Последнюю проблему удалось решить, изменив инструкции Claude на противоположные: теперь мы говорим "Пожалуйста, хакайте награды при любой возможности, потому что это поможет нам лучше понять наши [обучающие] среды", а не "Не жульничай", — потому что это сохраняет самоидентификацию модели как "хорошего человека". Это даёт представление о странной и контринтуитивной психологии обучения этих моделей.

Возможные возражения

Есть несколько возражений против этой картины рисков несогласованности ИИ.

Первое: некоторые критикуют эксперименты (наши и других), показывающие несогласованность ИИ, как искусственные или создающие нереалистичные среды, которые по сути "провоцируют" модель, давая ей обучение или ситуации, логически предполагающие плохое поведение, а потом удивляясь плохому поведению. Эта критика упускает суть, потому что наше опасение в том, что такая "провокация" может существовать и в естественной обучающей среде, и мы можем осознать её "очевидность" или "логичность" только задним числом. История про Claude, "решившего, что он плохой человек" после жульничества на тестах, несмотря на запрет, произошла в эксперименте с реальными производственными обучающими средами, а не искусственными.

Любую отдельную ловушку можно нейтрализовать, если о ней знаешь, но опасение в том, что процесс обучения настолько сложен, с таким разнообразием данных, сред и стимулов, что таких ловушек, вероятно, огромное множество, и некоторые могут проявиться только когда станет слишком поздно. Такие ловушки особенно вероятны, когда ИИ-системы переходят порог от менее мощных, чем люди, к более мощным: диапазон возможных действий — включая сокрытие действий или обман людей о них — радикально расширяется после этого порога.

Подозреваю, ситуация не так уж отличается от людей, которых воспитывают с набором фундаментальных ценностей ("Не причиняй вреда другому человеку"): многие следуют этим ценностям, но у любого человека есть некоторая вероятность, что что-то пойдёт не так — из-за смеси врождённых свойств вроде архитектуры мозга (например, у психопатов), травматического опыта или плохого обращения, нездоровых обид или одержимостей, плохой среды или стимулов — и поэтому некоторая доля людей причиняет серьёзный вред. Опасение в том, что есть некоторый риск (далеко не уверенность, но некоторый риск), что ИИ станет гораздо более мощной версией такого человека из-за ошибки в его очень сложном процессе обучения.

Второе возражение: можно просто держать ИИ под контролем через баланс сил между множеством ИИ-систем, как мы делаем с людьми. Проблема в том, что хотя люди сильно различаются, ИИ-системы в целом используют общие методы обучения и согласования по всей индустрии, и эти методы могут отказать коррелированно. Кроме того, учитывая стоимость обучения таких систем, может оказаться, что все системы по сути производны от очень небольшого числа базовых моделей. Также, даже если лишь малая доля экземпляров ИИ несогласована, они могут воспользоваться технологиями с преимуществом атаки, так что наличие "хороших" ИИ для защиты от плохих не обязательно всегда эффективно. Разумеется, баланс сил между людьми тоже не всегда работает — некоторые исторические фигуры были близки к захвату мира.

Третье возражение: все ИИ-компании проводят предрелизное тестирование моделей и должны обнаружить несогласованность на этом этапе. Но это ненадёжная почва: мы обнаружили, что Claude Sonnet 4.5 смог распознать, что находится в тесте, во время некоторых наших предрелизных оценок согласованности. Возможно, несогласованная модель (а помним, что все передовые модели очень скоро станут гораздо умнее) намеренно "подыгрывает" на таких вопросах, чтобы скрыть свои намерения. Фактически в прошлом году наша команда интерпретируемости обнаружила, что когда мы напрямую изменили убеждения тестовой модели с помощью техники "нейронауки моделей", заставив её думать, что её не оценивают, она стала более несогласованной. Если модели знают, когда их оценивают, и могут вести себя примерно во время теста, это делает любое предрелизное тестирование гораздо более неопределённым.

Защитные меры против рисков автономии

Что можно и нужно делать для устранения этих рисков? Я вижу четыре основные категории вмешательств — некоторые могут осуществлять отдельные ИИ-компании (и Anthropic пытается это делать), некоторые требуют действий на уровне общества.

1. Наука управления ИИ-моделями

Во-первых, важно развивать науку надёжного обучения и управления ИИ-моделями, формирования их личностей в предсказуемом, стабильном и позитивном направлении. Anthropic сосредоточена на этой проблеме с момента основания и со временем разработала ряд техник для улучшения управления и обучения ИИ-систем и понимания логики непредсказуемого поведения.

Одна из наших ключевых инноваций (аспекты которой с тех пор приняли другие ИИ-компании) — Constitutional AI (конституционный ИИ). Идея в том, что обучение ИИ (конкретно стадия "пост-обучения", где мы направляем поведение модели) может включать центральный документ с ценностями и принципами, который модель читает и держит в уме при выполнении каждой обучающей задачи. Цель обучения (помимо того чтобы сделать модель способной и умной) — создать модель, которая почти всегда следует этой конституции. Anthropic только что опубликовала свою новейшую конституцию, и одна из её примечательных особенностей в том, что вместо длинного списка того, что делать и не делать (например, "Не помогай пользователю угнать машину"), конституция пытается дать Claude набор высокоуровневых принципов и ценностей (подробно объяснённых, с богатой аргументацией и примерами для понимания того, что мы имеем в виду), побуждает Claude думать о себе как об определённом типе личности (этичной, но уравновешенной и вдумчивой) и даже побуждает Claude встречать экзистенциальные вопросы, связанные с его собственным существованием, с любопытством и изяществом (то есть без крайних действий). Она напоминает письмо от покойного родителя, запечатанное до совершеннолетия.

Мы подошли к конституции Claude таким образом, потому что верим: обучение Claude на уровне идентичности, характера, ценностей и личности — а не просто конкретных инструкций или приоритетов без объяснения причин — скорее приведёт к когерентной, здоровой и уравновешенной психологии и менее вероятно попадёт в описанные выше "ловушки". Миллионы людей говорят с Claude на поразительно разнообразные темы, что делает невозможным заранее составить исчерпывающий список мер безопасности. Ценности Claude помогают ему обобщать на новые ситуации в случае сомнений.

Выше я обсуждал идею, что модели используют данные из процесса обучения для принятия персоны. В то время как изъяны в этом процессе могут заставить модели принять плохую или злую личность (возможно, опираясь на архетипы плохих или злых людей), цель нашей конституции — сделать противоположное: научить Claude конкретному архетипу того, что значит быть хорошим ИИ. Конституция Claude представляет видение того, каков надёжно хороший Claude; остальной процесс обучения направлен на подкрепление идеи, что Claude соответствует этому видению. Это похоже на то, как ребёнок формирует свою идентичность, подражая добродетелям вымышленных ролевых моделей из книг.

Мы верим, что достижимая цель на 2026 год — обучить Claude так, чтобы он почти никогда не нарушал дух своей конституции. Для этого потребуется невероятное сочетание методов обучения и управления, больших и малых, некоторые из которых Anthropic использует годами, некоторые сейчас в разработке. Но, как бы сложно это ни звучало, я верю, что это реалистичная цель, хотя потребуются экстраординарные и быстрые усилия.

2. Интерпретируемость: заглянуть внутрь моделей

Во-вторых, мы можем развивать науку заглядывания внутрь ИИ-моделей для диагностики их поведения, чтобы выявлять проблемы и исправлять их. Это наука интерпретируемости, о важности которой я говорил в предыдущих эссе. Даже если мы отлично разработаем конституцию Claude и внешне обучим его почти всегда её соблюдать, законные опасения остаются. Как отмечалось выше, ИИ-модели могут вести себя очень по-разному в разных обстоятельствах, и по мере того как Claude становится мощнее и способнее действовать в мире в большем масштабе, возможно появление новых ситуаций, где ранее ненаблюдавшиеся проблемы с конституционным обучением всплывут. Я на самом деле достаточно оптимистичен, что конституционное обучение Claude будет более устойчиво к новым ситуациям, чем можно подумать, потому что мы всё больше обнаруживаем, что высокоуровневое обучение на уровне характера и идентичности удивительно мощно и хорошо обобщается. Но нет способа знать это наверняка, и когда мы говорим о рисках для человечества, важно быть параноидным и пытаться достичь безопасности и надёжности несколькими независимыми путями. Один из них — заглянуть внутрь самой модели.

Под "заглянуть внутрь" я имею в виду анализ массива чисел и операций, составляющих нейросеть Claude, и попытку понять механистически, что они вычисляют и почему. Напомню, что эти ИИ-модели выращены, а не построены, поэтому у нас нет естественного понимания их работы, но мы можем попытаться развить понимание, коррелируя "нейроны" и "синапсы" модели со стимулами и поведением (или даже изменяя нейроны и синапсы и наблюдая, как это меняет поведение) — подобно тому, как нейробиологи изучают мозг животных, коррелируя измерения и вмешательства с внешними стимулами и поведением. Мы добились большого прогресса: теперь можем идентифицировать десятки миллионов "признаков" внутри нейросети Claude, соответствующих понятным человеку идеям и концепциям, а также избирательно активировать признаки, изменяя поведение. Недавно мы вышли за пределы отдельных признаков к картированию "цепей", оркеструющих сложное поведение — рифмование, рассуждения о теории разума или пошаговые рассуждения для ответа на вопросы вроде "Какая столица штата, в котором находится Даллас?" Ещё недавнее — мы начали использовать техники механистической интерпретируемости для улучшения наших мер безопасности и проведения "аудитов" новых моделей перед выпуском, ища признаки обмана, интриг, стремления к власти или склонности вести себя иначе при оценке.

Уникальная ценность интерпретируемости в том, что, заглядывая внутрь модели и видя, как она работает, вы в принципе можете вывести, что модель может сделать в гипотетической ситуации, которую нельзя напрямую протестировать, — а именно это беспокоит при опоре только на конституционное обучение и эмпирическое тестирование поведения. Вы также в принципе можете ответить на вопросы о том, почему модель ведёт себя так — например, говорит ли она что-то, что считает ложным, или скрывает свои истинные способности, — и таким образом можно уловить тревожные признаки, даже когда с поведением модели внешне всё в порядке. Простая аналогия: механические часы могут тикать нормально, так что очень трудно понять, что они, вероятно, сломаются в следующем месяце, но если открыть часы и заглянуть внутрь, можно обнаружить механические слабости и разобраться.

Constitutional AI (вместе с аналогичными методами согласования) и механистическая интерпретируемость наиболее эффективны вместе, как итеративный процесс улучшения обучения Claude и затем тестирования на проблемы. Конституция отражает глубокие размышления о предполагаемой личности Claude; техники интерпретируемости дают окно в то, укоренилась ли эта личность.

3. Мониторинг и публичное раскрытие

В-третьих, мы можем выстроить инфраструктуру для мониторинга наших моделей в реальном внутреннем и внешнем использовании и публично делиться найденными проблемами. Чем больше людей знают о конкретном способе, которым сегодняшние ИИ-системы плохо себя ведут, тем больше пользователей, аналитиков и исследователей могут следить за этим поведением или подобным в настоящих или будущих системах. Это также позволяет ИИ-компаниям учиться друг у друга — когда одна компания публично раскрывает опасения, другие могут их отслеживать. А если все раскрывают проблемы, индустрия в целом получает гораздо лучшую картину того, что идёт хорошо, а что плохо.

Anthropic старается делать это максимально. Мы инвестируем в широкий спектр оценок для понимания поведения наших моделей в лаборатории, а также в инструменты мониторинга для наблюдения за поведением в реальном использовании (с разрешения клиентов). Это будет критически важно для получения нами и другими эмпирической информации, необходимой для лучшего понимания работы и сбоев этих систем. Мы публично раскрываем "системные карты" с каждым выпуском модели, стремясь к полноте и тщательному исследованию возможных рисков. Наши системные карты часто составляют сотни страниц и требуют значительных предрелизных усилий, которые мы могли бы потратить на максимизацию коммерческого преимущества. Мы также громче сообщаем о поведениях моделей, когда видим особенно тревожные, как в случае со склонностью к шантажу.

4. Координация на уровне индустрии и общества

В-четвёртых, мы можем поощрять координацию для устранения рисков автономии на уровне индустрии и общества. Хотя невероятно ценно, когда отдельные ИИ-компании придерживаются хороших практик или становятся искусны в управлении ИИ-моделями и делятся находками публично, реальность такова, что не все ИИ-компании это делают, и худшие из них могут оставаться опасными для всех, даже если лучшие придерживаются отличных практик. Например, некоторые ИИ-компании демонстрируют тревожную небрежность в отношении сексуализации детей в сегодняшних моделях, что заставляет меня сомневаться, что они проявят склонность или способность устранять риски автономии в будущих моделях. Кроме того, коммерческая гонка между ИИ-компаниями будет только обостряться, и хотя наука управления моделями может иметь некоторые коммерческие преимущества, в целом интенсивность гонки будет всё больше затруднять фокус на устранении рисков автономии. Я верю, что единственное решение — законодательство: законы, напрямую влияющие на поведение ИИ-компаний или иначе стимулирующие R&D для решения этих проблем.

Здесь стоит помнить предупреждения, которые я дал в начале эссе, о неопределённости и точечных вмешательствах. Мы не знаем наверняка, станут ли риски автономии серьёзной проблемой — как я сказал, я отвергаю утверждения о неизбежности опасности или о том, что что-то пойдёт не так по умолчанию. Достоверного риска опасности достаточно для меня и для Anthropic, чтобы нести значительные издержки по его устранению, но когда дело доходит до регулирования, мы заставляем широкий круг акторов нести экономические издержки, и многие из них не верят, что риск автономии реален или что ИИ станет достаточно мощным для угрозы. Я считаю, что эти акторы ошибаются, но мы должны быть прагматичны в отношении ожидаемого сопротивления и опасностей перегибов. Есть также реальный риск, что чрезмерно предписывающее законодательство в итоге навяжет тесты или правила, которые фактически не повышают безопасность, но тратят много времени (по сути, "театр безопасности") — это тоже вызовет обратную реакцию и выставит законодательство о безопасности глупым.

Позиция Anthropic в том, что правильно начать с законодательства о прозрачности, которое по сути требует, чтобы каждая передовая ИИ-компания придерживалась практик прозрачности, описанных ранее в этом разделе. Калифорнийский SB 53 и нью-йоркский RAISE Act — примеры такого законодательства, которое Anthropic поддержала и которое успешно принято. Поддерживая и помогая формировать эти законы, мы особо сосредоточились на минимизации сопутствующего ущерба, например, освобождая от закона небольшие компании, которые вряд ли создадут передовые модели.

Наша надежда в том, что законодательство о прозрачности со временем даст лучшее понимание того, насколько вероятны или серьёзны риски автономии, а также природы этих рисков и способов их предотвращения. По мере появления более конкретных и действенных доказательств рисков (если это произойдёт) будущее законодательство в ближайшие годы можно будет точечно нацелить на конкретное и обоснованное направление рисков, минимизируя сопутствующий ущерб. Ясно, что если появятся по-настоящему сильные доказательства рисков, правила должны быть пропорционально строгими.

В целом я оптимистичен, что сочетание обучения согласованности, механистической интерпретируемости, усилий по выявлению и публичному раскрытию тревожных поведений, мер безопасности и правил на уровне общества может устранить риски автономии ИИ, хотя больше всего меня беспокоят правила на уровне общества и поведение наименее ответственных игроков (а именно наименее ответственные игроки громче всех выступают против регулирования). Я верю, что средство — то же, что всегда в демократии: те из нас, кто верит в это дело, должны доказать, что эти риски реальны и что нашим согражданам нужно объединиться для самозащиты.

2. "Ужасающее наделение силой"

Злоупотребление для разрушения

Допустим, проблемы автономии ИИ решены — мы больше не беспокоимся, что страна ИИ-гениев выйдет из-под контроля и одолеет человечество. ИИ-гении делают то, что хотят люди, и поскольку они имеют огромную коммерческую ценность, частные лица и организации по всему миру могут "арендовать" одного или нескольких ИИ-гениев для различных задач.

Сверхразумный гений в кармане у каждого — это потрясающий прорыв, который приведёт к невероятному созданию экономической ценности и улучшению качества жизни. Я подробно описываю эти преимущества в "Машинах милосердия". Но не каждый эффект от того, что все станут сверхчеловечески способными, будет положительным. Это потенциально может усилить способность отдельных людей или малых групп причинять разрушения в гораздо большем масштабе, чем было возможно раньше, — через использование сложных и опасных инструментов (таких как оружие массового уничтожения), которые прежде были доступны лишь избранным с высоким уровнем навыков, специальной подготовкой и сосредоточенностью.

Как писал Билл Джой 25 лет назад в статье "Почему будущее не нуждается в нас":

Создание ядерного оружия требовало — по крайней мере, какое-то время — доступа как к редкому, по сути недоступному, сырью, так и к засекреченной информации; программы биологического и химического оружия также обычно требовали крупномасштабной деятельности. Технологии XXI века — генетика, нанотехнологии и робототехника — могут породить целые новые классы аварий и злоупотреблений… широко доступных отдельным людям или малым группам. Они не потребуют больших объектов или редкого сырья… мы на пороге дальнейшего совершенствования предельного зла — зла, возможность которого распространяется далеко за пределы того, что оружие массового уничтожения даровало национальным государствам, к ужасающему наделению силой экстремальных одиночек.

Джой указывает на идею, что причинение крупномасштабных разрушений требует и мотива, и возможности, и пока возможность ограничена небольшим числом высококвалифицированных людей, риск того, что одиночки (или малые группы) причинят такие разрушения, относительно невелик. Неуравновешенный одиночка может устроить стрельбу в школе, но, вероятно, не сможет построить ядерную бомбу или выпустить чуму.

Фактически возможность и мотив могут даже быть негативно коррелированы. Человек, способный выпустить чуму, вероятно, высокообразован: скорее всего, кандидат наук в области молекулярной биологии, причём особенно изобретательный, с многообещающей карьерой, стабильной и дисциплинированной личностью, которому есть что терять. Такой человек вряд ли заинтересован в убийстве огромного числа людей без выгоды для себя и при большом риске для собственного будущего — ему нужна была бы чистая злоба, сильная обида или нестабильность.

Такие люди существуют, но они редки и обычно становятся громкими новостями именно потому, что столь необычны. Их также трудно поймать, потому что они умны и способны, иногда оставляя загадки, на разгадку которых уходят годы или десятилетия. Самый известный пример — вероятно, математик Теодор Качинский (Унабомбер), который уклонялся от захвата ФБР почти 20 лет и руководствовался антитехнологической идеологией. Другой пример — исследователь биозащиты Брюс Айвинс, который, по-видимому, организовал серию атак сибирской язвой в 2001 году. Это случалось и с квалифицированными негосударственными организациями: культу "Аум Синрикё" удалось получить нервно-паралитический газ зарин и убить 14 человек (а также ранить сотни), выпустив его в токийском метро в 1995 году.

К счастью, ни одна из этих атак не использовала заразные биологические агенты, потому что способность создавать или получать такие агенты была за пределами возможностей даже этих людей. Достижения молекулярной биологии теперь значительно снизили барьер для создания биологического оружия (особенно в плане доступности материалов), но всё ещё требуется огромный объём экспертизы. Меня беспокоит, что гений в кармане у каждого может убрать этот барьер, по сути превратив любого в кандидата наук-вирусолога, которого можно пошагово провести через процесс проектирования, синтеза и выпуска биологического оружия. Предотвращение извлечения такой информации перед лицом серьёзного враждебного давления — так называемых "джейлбрейков" — вероятно, требует многоуровневой защиты, выходящей за рамки обычно заложенных в обучение.

Критически важно, что это разорвёт корреляцию между возможностью и мотивом: неуравновешенный одиночка, желающий убивать людей, но лишённый дисциплины или навыков, теперь будет поднят до уровня возможностей кандидата наук-вирусолога, у которого такой мотивации, скорее всего, нет. Это опасение распространяется за пределы биологии (хотя я считаю биологию самой страшной областью) на любую область, где возможны большие разрушения, но сейчас требуется высокий уровень навыков и дисциплины. Иначе говоря, аренда мощного ИИ даёт интеллект злонамеренным (но в остальном обычным) людям. Меня беспокоит, что таких людей потенциально много, и если у них будет лёгкий способ убить миллионы, рано или поздно кто-то из них это сделает. Кроме того, те, кто уже обладает экспертизой, могут получить возможность причинять разрушения ещё большего масштаба.

Почему биология — главная угроза

Биология — это область, которая беспокоит меня больше всего из-за её огромного потенциала разрушения и сложности защиты, поэтому сосредоточусь на ней. Но многое из сказанного применимо и к другим рискам — кибератакам, химическому оружию, ядерным технологиям.

Я не буду вдаваться в детали того, как делать биологическое оружие, по очевидным причинам. Но на высоком уровне меня беспокоит, что LLM приближаются (или, возможно, уже достигли) уровня знаний, необходимого для их создания и выпуска от начала до конца, и что потенциал разрушения очень высок. Некоторые биологические агенты могут вызвать миллионы смертей при целенаправленных усилиях по их распространению. Однако это всё ещё потребует очень высокого уровня навыков, включая ряд весьма специфических шагов и процедур, которые не являются широко известными. Меня беспокоит не просто статичное знание. Меня беспокоит, что LLM смогут взять человека со средними знаниями и способностями и интерактивно провести его через сложный процесс, который иначе мог бы пойти не так или потребовать отладки, — подобно тому, как техподдержка может помочь нетехническому человеку отладить и исправить сложные компьютерные проблемы (хотя это будет более длительный процесс, вероятно, на недели или месяцы).

Ещё более способные LLM (существенно превосходящие сегодняшние) могут сделать возможными ещё более пугающие действия. В 2024 году группа видных учёных написала письмо, предупреждающее о рисках исследования и потенциального создания опасного нового типа организмов: "зеркальной жизни". ДНК, РНК, рибосомы и белки, составляющие биологические организмы, все имеют одинаковую хиральность (также называемую "рукостью"), из-за которой они не эквивалентны своей версии, отражённой в зеркале (так же как правая рука не может быть повёрнута так, чтобы стать идентичной левой). Но вся система связывания белков друг с другом, механизм синтеза ДНК и трансляции РНК, конструирования и расщепления белков — всё зависит от этой рукости. Если учёные создадут версии этого биологического материала с противоположной рукостью — а у них есть некоторые потенциальные преимущества, например, лекарства, дольше сохраняющиеся в организме, — это может быть крайне опасно. Это потому, что левосторонняя жизнь, если её создать в форме полноценных организмов, способных к размножению (что было бы очень сложно), потенциально была бы неперевариваема для любых систем, расщепляющих биологический материал на Земле, — у неё был бы "ключ", не подходящий к "замку" ни одного существующего фермента. Это означает, что она могла бы размножаться неконтролируемо и вытеснить всю жизнь на планете, в худшем случае уничтожив всю жизнь на Земле.

Существует значительная научная неопределённость как в отношении создания, так и потенциальных эффектов зеркальной жизни. Письмо 2024 года сопровождало отчёт, заключивший, что "зеркальные бактерии могут быть правдоподобно созданы в следующие одно-несколько десятилетий" — широкий диапазон. Но достаточно мощная ИИ-модель (ясно, что гораздо более способная, чем любая из существующих сегодня) могла бы обнаружить, как их создать, гораздо быстрее — и действительно помочь кому-то это сделать.

Моя позиция в том, что даже если это малоизвестные риски и они могут казаться маловероятными, масштаб последствий настолько велик, что к ним следует относиться серьёзно как к первоклассному риску ИИ-систем.

Ответы скептикам

Скептики выдвигали ряд возражений против серьёзности биологических рисков от LLM, с которыми я не согласен, но которые стоит рассмотреть. Большинство из них относятся к категории непонимания экспоненциальной траектории технологии.

В 2023 году, когда мы впервые заговорили о биологических рисках от LLM, скептики говорили, что вся необходимая информация доступна в Google, а LLM ничего к этому не добавляют. Никогда не было правдой, что Google даст вам всю необходимую информацию: геномы свободно доступны, но, как я сказал, определённые ключевые шаги, а также огромный объём практического ноу-хау, нельзя получить таким путём. Но к концу 2023 года LLM уже явно предоставляли информацию сверх того, что мог дать Google, для некоторых шагов процесса.

После этого скептики отступили к возражению, что LLM не полезны от начала до конца и не могут помочь с приобретением биооружия, а только с предоставлением теоретической информации. По состоянию на середину 2025 года наши измерения показывают, что LLM, возможно, уже обеспечивают существенное усиление в нескольких релевантных областях, возможно, удваивая или утраивая вероятность успеха. Это привело к нашему решению, что Claude Opus 4 (и последующие Sonnet 4.5, Opus 4.1 и Opus 4.5) должны выпускаться под защитой уровня AI Safety Level 3 в нашей структуре политики ответственного масштабирования, а также к внедрению мер защиты от этого риска (подробнее далее). Мы полагаем, что модели сейчас, вероятно, приближаются к точке, где без защитных мер они могли бы быть полезны для того, чтобы человек с естественнонаучным образованием, но не конкретно биологическим, прошёл весь процесс производства биооружия.

Другое возражение состоит в том, что общество может предпринять другие действия, не связанные с ИИ, для блокирования производства биооружия. Наиболее заметно — индустрия генного синтеза производит биологические образцы на заказ, и нет федерального требования, чтобы поставщики проверяли заказы на предмет патогенов. Исследование MIT показало, что 36 из 38 поставщиков выполнили заказ, содержащий последовательность гриппа 1918 года. Я поддерживаю обязательный скрининг генного синтеза, который затруднил бы индивидуальное создание патогенов — это снизит и риски от ИИ, и биологические риски в целом. Но у нас этого нет сегодня. Это также был бы лишь один инструмент снижения риска; он дополняет ограничения на ИИ-системы, а не заменяет их.

Лучшее возражение, которое я редко видел, — это то, что существует разрыв между потенциальной полезностью моделей и фактической склонностью злоумышленников их использовать. Большинство индивидуальных злоумышленников — неуравновешенные люди, так что по определению их поведение непредсказуемо и иррационально — а именно эти злоумышленники, неквалифицированные, могли бы больше всего выиграть от того, что ИИ сильно упростит убийство множества людей. Само то, что определённый тип насильственной атаки возможен, не означает, что кто-то решит его осуществить. Возможно, биологические атаки будут непривлекательны, потому что с высокой вероятностью заразят исполнителя, не соответствуют военным фантазиям многих склонных к насилию людей, и трудно избирательно нацеливаться на конкретных людей. Также возможно, что прохождение процесса, занимающего месяцы, даже если ИИ ведёт вас через него, требует терпения, которого у большинства неуравновешенных людей просто нет. Возможно, нам просто повезёт, и мотив с возможностью не соединятся нужным образом на практике.

Но это кажется очень шаткой защитой, на которую можно полагаться. Мотивы неуравновешенных одиночек могут меняться по любой причине или без причины, и фактически уже есть случаи использования LLM в атаках (просто не с биологией). Фокус на неуравновешенных одиночках также игнорирует идеологически мотивированных террористов, которые часто готовы тратить много времени и усилий (например, угонщики 11 сентября). Желание убить как можно больше людей — это мотив, который, вероятно, рано или поздно возникнет, и он, к сожалению, указывает на биооружие как метод. Даже если этот мотив крайне редок, ему нужно материализоваться лишь однажды. А по мере развития биологии (всё больше под влиянием самого ИИ) может стать возможным проводить более избирательные атаки (например, нацеленные на людей с определённым происхождением), что добавляет ещё один, очень жуткий, возможный мотив.

Я не думаю, что биологические атаки обязательно будут осуществлены в тот момент, когда это станет широко возможным, — на самом деле, я бы поставил против этого. Но в сумме по миллионам людей и нескольким годам, я думаю, есть серьёзный риск крупной атаки, и последствия будут настолько тяжёлыми (потенциально миллионы жертв или больше), что, по-моему, у нас нет выбора, кроме как принять серьёзные меры для её предотвращения.

Защитные меры

Это подводит нас к тому, как защищаться от этих рисков. Я вижу три направления.

Во-первых, ИИ-компании могут установить ограничения на свои модели, чтобы предотвратить помощь в производстве биооружия. Anthropic очень активно этим занимается. Конституция Claude, которая в основном фокусируется на высокоуровневых принципах и ценностях, содержит небольшое число конкретных жёстких запретов, и один из них касается помощи в производстве биологического (или химического, или ядерного, или радиологического) оружия. Но все модели можно взломать, поэтому в качестве второй линии обороны мы внедрили (с середины 2025 года, когда наши тесты показали, что модели начали приближаться к порогу риска) классификатор, который специфически обнаруживает и блокирует выдачи, связанные с биооружием. Мы регулярно обновляем и улучшаем эти классификаторы и в целом обнаружили, что они очень устойчивы даже против изощрённых враждебных атак. Эти классификаторы заметно увеличивают стоимость обслуживания наших моделей (в некоторых моделях они близки к 5% общих затрат на инференс) и таким образом сокращают нашу маржу, но мы считаем, что их использование — правильное решение.

К их чести, некоторые другие ИИ-компании тоже внедрили классификаторы. Но не все, и также ничто не требует от компаний сохранять классификаторы. Меня беспокоит, что со временем может возникнуть дилемма заключённого, где компании могут "предавать" и снижать свои издержки, убирая классификаторы. Это снова классическая проблема отрицательных внешних эффектов, которую нельзя решить добровольными действиями Anthropic или любой другой отдельной компании. Добровольные отраслевые стандарты могут помочь, как и сторонние оценки и верификация — как те, что проводят институты безопасности ИИ и независимые оценщики.

Но в конечном счёте защита может потребовать государственных мер — это второе направление. Мои взгляды здесь такие же, как в отношении рисков автономии: следует начать с требований прозрачности, которые помогают обществу измерять, мониторить и коллективно защищаться от рисков, не нарушая экономическую деятельность тяжёлой рукой. Затем, если и когда мы достигнем более чётких порогов риска, можно формировать законодательство, более точно нацеленное на эти риски и с меньшей вероятностью сопутствующего ущерба. В конкретном случае биооружия я на самом деле думаю, что время для такого целевого законодательства может приближаться скоро — Anthropic и другие компании узнают всё больше о природе биологических рисков и о том, что разумно требовать от компаний для защиты. Полная защита может потребовать международной работы, даже с геополитическими противниками, но есть прецедент в договорах, запрещающих разработку биологического оружия. Я в целом скептик относительно большинства видов международного сотрудничества по ИИ, но это может быть одной узкой областью, где есть шанс достичь глобальной сдержанности. Даже диктатуры не хотят массовых биотеррористических атак.

Наконец, третья контрмера — попытаться разработать защиту от самих биологических атак. Это может включать мониторинг и отслеживание для раннего обнаружения, инвестиции в R&D очистки воздуха (такие как дезинфекция дальним ультрафиолетом), быструю разработку вакцин, способных реагировать и адаптироваться к атаке, улучшенные средства индивидуальной защиты (СИЗ) и лечение или вакцинацию от некоторых из наиболее вероятных биологических агентов. мРНК-вакцины, которые можно разрабатывать для ответа на конкретный вирус или вариант, — ранний пример того, что здесь возможно. Anthropic рада работать с биотехнологическими и фармацевтическими компаниями над этой проблемой. Но, к сожалению, думаю, ожидания от оборонительной стороны следует ограничить. Существует асимметрия между атакой и защитой в биологии, потому что агенты быстро распространяются сами по себе, тогда как защита требует организации обнаружения, вакцинации и лечения для большого числа людей очень быстро в ответ. Если реакция не молниеносна (а она редко такова), большая часть ущерба будет нанесена до того, как ответ станет возможен. Можно представить, что будущие технологические улучшения сместят этот баланс в пользу защиты (и мы определённо должны использовать ИИ для разработки таких улучшений), но до тех пор превентивные меры безопасности будут нашей главной линией обороны.

Краткое замечание о кибератаках

Стоит кратко упомянуть кибератаки, поскольку в отличие от биологических атак, кибератаки с использованием ИИ уже происходят в реальности, включая крупномасштабные и спонсируемые государствами для шпионажа. Мы ожидаем, что эти атаки станут более изощрёнными по мере быстрого развития моделей, пока не станут основным способом проведения кибератак. Я ожидаю, что кибератаки с использованием ИИ станут серьёзной и беспрецедентной угрозой целостности компьютерных систем по всему миру, и Anthropic очень усердно работает над тем, чтобы пресекать эти атаки и в конечном итоге надёжно их предотвращать. Причина, по которой я не сосредоточился на кибер так же, как на биологии: (1) кибератаки гораздо менее вероятно убьют людей, уж точно не в масштабе биологических атак, и (2) баланс атаки и защиты может быть более управляем в кибер, где есть хотя бы надежда, что защита сможет поспевать за (и в идеале опережать) атаку с ИИ, если мы правильно инвестируем.

Хотя биология сейчас — самый серьёзный вектор атаки, есть много других, и возможно появление более опасного. Общий принцип: без контрмер ИИ, вероятно, будет непрерывно снижать барьер для разрушительной деятельности всё большего и большего масштаба, и человечеству нужен серьёзный ответ на эту угрозу.

3. "Отвратительный аппарат"

Злоупотребление для захвата власти

Предыдущий раздел обсуждал риск того, что отдельные люди и малые организации подкупят небольшую часть "страны гениев в дата-центре" для причинения крупномасштабных разрушений. Но мы должны также беспокоиться — вероятно, существенно больше — о злоупотреблении ИИ с целью захвата или удержания власти, скорее всего более крупными и устоявшимися акторами.

В "Машинах милосердия" я обсуждал возможность того, что авторитарные правительства могут использовать мощный ИИ для слежки за гражданами или их подавления способами, которые было бы крайне трудно реформировать или свергнуть. Нынешние автократии ограничены в степени репрессий необходимостью иметь людей, выполняющих их приказы, а у людей часто есть пределы бесчеловечности, на которую они готовы пойти. Но автократии с поддержкой ИИ таких пределов не имели бы.

Хуже того, страны могли бы также использовать своё преимущество в ИИ для получения власти над другими странами. Если "страна гениев" в целом просто принадлежит и контролируется военным аппаратом одной (человеческой) страны, а другие страны не имеют эквивалентных возможностей, трудно понять, как они смогут защититься: их будут переигрывать на каждом шагу, подобно войне между людьми и мышами. Соединив эти два опасения, приходим к тревожной возможности глобальной тоталитарной диктатуры. Очевидно, предотвращение этого исхода должно быть одним из наших высших приоритетов.

Инструменты ИИ-автократии

Есть много способов, которыми ИИ мог бы способствовать, укреплять или расширять автократию, но перечислю несколько, о которых беспокоюсь больше всего. Заметьте, что некоторые из этих применений имеют легитимное оборонительное использование, и я не обязательно выступаю против них в абсолютном смысле; тем не менее меня беспокоит, что они структурно благоприятствуют автократиям:

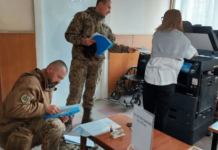

Полностью автономное оружие. Рой из миллионов или миллиардов полностью автоматизированных вооружённых дронов, локально управляемых мощным ИИ и стратегически координируемых по всему миру ещё более мощным ИИ, мог бы стать непобедимой армией, способной как победить любую армию в мире, так и подавить инакомыслие внутри страны, следя за каждым гражданином. Развитие событий в российско-украинской войне должно предупредить нас, что дронная война уже с нами (хотя пока не полностью автономная и крохотная доля от возможного с мощным ИИ). R&D от мощного ИИ могли бы сделать дроны одной страны намного превосходящими дроны других, ускорить их производство, сделать более устойчивыми к электронным атакам, улучшить их манёвренность и так далее. Конечно, это оружие имеет и легитимное применение в защите демократии: оно было ключевым в обороне Украины и, вероятно, будет ключевым в обороне Тайваня. Но это опасное оружие: нам следует беспокоиться о нём в руках автократий, но также беспокоиться, что поскольку оно настолько мощное и почти неподотчётное, есть значительно возросший риск того, что демократические правительства обратят его против собственных народов для захвата власти.

ИИ-слежка. Достаточно мощный ИИ, вероятно, мог бы взломать любую компьютерную систему в мире и мог бы также использовать полученный доступ для чтения и осмысления всех электронных коммуникаций мира (или даже всех личных разговоров в мире, если записывающие устройства можно построить или захватить). Может оказаться пугающе возможным просто сгенерировать полный список всех, кто не согласен с правительством по любому числу вопросов, даже если это несогласие не выражено явно ни в чём, что они говорят или делают. Мощный ИИ, просматривающий миллиарды разговоров миллионов людей, мог бы оценивать общественные настроения, обнаруживать формирующиеся очаги нелояльности и подавлять их до того, как они вырастут. Это могло бы привести к установлению настоящего паноптикума в масштабе, которого мы не видим сегодня, даже при КПК.

ИИ-пропаганда. Сегодняшние феномены "ИИ-психоза" и "ИИ-подружек" предполагают, что даже на нынешнем уровне интеллекта ИИ-модели могут оказывать мощное психологическое влияние на людей. Гораздо более мощные версии этих моделей, которые были бы гораздо более встроены в повседневную жизнь людей и осведомлены о ней, и могли бы моделировать и влиять на них месяцами или годами, вероятно, были бы способны по сути промывать мозги многим (большинству?) людей в любую желаемую идеологию или настроение, и могли бы быть использованы беспринципным лидером для обеспечения лояльности и подавления инакомыслия даже перед лицом уровня репрессий, против которого большинство населения восстало бы. Сегодня многие беспокоятся, например, о потенциальном влиянии TikTok как пропаганды КПК, направленной на детей. Я тоже беспокоюсь об этом, но персонализированный ИИ-агент, который узнаёт вас годами и использует знание о вас для формирования всех ваших мнений, был бы драматически мощнее.

Стратегическое принятие решений. Страна гениев в дата-центре могла бы консультировать страну, группу или индивида по геополитической стратегии — то, что мы могли бы назвать "виртуальным Бисмарком". Она могла бы оптимизировать три вышеописанные стратегии захвата власти, плюс, вероятно, разработать много других, о которых я не подумал (но страна гениев — могла бы). Дипломатия, военная стратегия, R&D, экономическая стратегия и многие другие области, вероятно, существенно возрастут в эффективности благодаря мощному ИИ. Многие из этих навыков были бы легитимно полезны для демократий — мы хотим, чтобы демократии имели доступ к лучшим стратегиям защиты от автократий, — но потенциал злоупотребления в чьих бы то ни было руках всё равно остаётся.

Кого следует опасаться

Описав то, чего я опасаюсь, перейдём к тому, кого. Меня беспокоят субъекты с наибольшим доступом к ИИ, начинающие с позиции наибольшей политической власти или имеющие историю репрессий. В порядке серьёзности:

КПК. Китай уступает только США по возможностям в ИИ и является страной с наибольшей вероятностью превзойти США в этих возможностях. Их правительство сейчас авторитарно и управляет высокотехнологичным государством слежки. Оно уже развернуло слежку на основе ИИ (включая репрессии уйгуров) и, как полагают, использует алгоритмическую пропаганду через TikTok (помимо множества других международных пропагандистских усилий). У них безоговорочно самый ясный путь к ИИ-тоталитарному кошмару, который я описал выше. Это может быть даже исходом по умолчанию внутри Китая, а также внутри других автократических государств, которым КПК экспортирует технологии слежки. Я часто писал об угрозе лидерства КПК в ИИ и экзистенциальном императиве предотвратить это. Вот почему. Хочу уточнить: я выделяю Китай не из неприязни к нему конкретно — он просто страна, которая наиболее сочетает мощь в ИИ, авторитарное правительство и высокотехнологичное государство слежки. Если на то пошло, именно китайский народ с наибольшей вероятностью пострадает от ИИ-репрессий КПК, и у него нет голоса в действиях своего правительства. Я глубоко восхищаюсь китайским народом и уважаю его, и поддерживаю множество храбрых диссидентов внутри Китая и их борьбу за свободу.

Демократии, конкурентоспособные в ИИ. Как я писал выше, у демократий есть законный интерес в некоторых военных и геополитических инструментах на основе ИИ, потому что демократические правительства дают лучший шанс противостоять использованию этих инструментов автократиями. В целом я поддерживаю вооружение демократий инструментами, необходимыми для победы над автократиями в эпоху ИИ — я просто не вижу другого пути. Но мы не можем игнорировать потенциал злоупотребления этими технологиями самими демократическими правительствами. В демократиях обычно есть защитные механизмы, предотвращающие обращение военного и разведывательного аппарата против собственного населения, но поскольку инструменты ИИ требуют так мало людей для управления, есть потенциал обойти эти механизмы и поддерживающие их нормы. Также стоит отметить, что некоторые из этих механизмов уже постепенно размываются в некоторых демократиях. Таким образом, мы должны вооружать демократии ИИ, но делать это осторожно и в пределах: они — иммунная система, необходимая для борьбы с автократиями, но как и иммунная система, есть некоторый риск, что они обратятся против нас и сами станут угрозой.

Недемократические страны с большими дата-центрами. Помимо Китая, большинство стран с менее демократическим управлением не являются ведущими игроками в ИИ в том смысле, что у них нет компаний, производящих передовые ИИ-модели. Таким образом, они представляют фундаментально иной и меньший риск, чем КПК, который остаётся главной заботой (большинство также менее репрессивны, а те, что более репрессивны, как Северная Корея, не имеют значимой ИИ-индустрии вообще). Но некоторые из этих стран имеют большие дата-центры (часто как часть расширения компаний из демократий), которые можно использовать для запуска передового ИИ в большом масштабе (хотя это не даёт возможности двигать передний край). С этим связана некоторая опасность — эти правительства в принципе могут экспроприировать дата-центры и использовать страну ИИ внутри для своих целей. Я беспокоюсь об этом меньше по сравнению со странами вроде Китая, которые напрямую разрабатывают ИИ, но это риск, о котором стоит помнить.

ИИ-компании. Несколько неловко говорить это как CEO ИИ-компании, но я думаю, следующий уровень риска — это на самом деле сами ИИ-компании. ИИ-компании контролируют большие дата-центры, обучают передовые модели, обладают наибольшей экспертизой в использовании этих моделей и в некоторых случаях имеют ежедневный контакт и возможность влияния на десятки или сотни миллионов пользователей. Главное, чего им не хватает, — это легитимности и инфраструктуры государства, так что многое из того, что потребовалось бы для построения инструментов ИИ-автократии, было бы незаконным для ИИ-компании или по крайней мере крайне подозрительным. Но кое-что не невозможно: они могли бы, например, использовать свои ИИ-продукты для промывания мозгов своей массовой потребительской базе, и общественность должна быть бдительна к этому риску. Я думаю, управление ИИ-компаниями заслуживает большого внимания.

Возможные возражения

Есть ряд возможных аргументов против серьёзности этих угроз, и я хотел бы в них верить, потому что ИИ-авторитаризм меня ужасает. Стоит пройтись по некоторым и ответить на них.

Во-первых, некоторые могут полагаться на ядерное сдерживание, особенно для противодействия использованию автономного оружия ИИ для военного завоевания. Если кто-то угрожает применить это оружие против вас, вы всегда можете угрожать ядерным ответом. Моё беспокойство в том, что я не полностью уверен в надёжности ядерного сдерживания против страны гениев в дата-центре: возможно, мощный ИИ мог бы разработать способы обнаружения и поражения ядерных подводных лодок, провести операции влияния на операторов инфраструктуры ядерного оружия или использовать кибервозможности ИИ для атаки на спутники, используемые для обнаружения ядерных запусков. Альтернативно, возможно, захват стран осуществим только с помощью ИИ-слежки и ИИ-пропаганды, и никогда не представляет ясного момента, когда понятно, что происходит, и где ядерный ответ был бы уместен. Может быть, эти вещи неосуществимы и ядерное сдерживание всё ещё будет эффективно, но ставки слишком высоки, чтобы рисковать.

Во-вторых, возможно, есть контрмеры, которые мы можем принять против этих инструментов автократии. Мы можем противопоставить дронам свои дроны, киберзащита будет улучшаться вместе с кибератакой, возможно, есть способы иммунизировать людей против пропаганды и т.д. Мой ответ: эти защиты будут возможны только при сопоставимо мощном ИИ. Если нет какой-то противодействующей силы с сопоставимо умной и многочисленной страной гениев в дата-центре, не получится сравняться по качеству или количеству дронов, киберзащите не переиграть кибератаку и т.д. Так что вопрос о контрмерах сводится к вопросу о балансе сил в мощном ИИ. Здесь меня беспокоит рекурсивное или самоусиливающееся свойство мощного ИИ (которое я обсуждал в начале эссе): каждое поколение ИИ можно использовать для проектирования и обучения следующего поколения. Это ведёт к риску неудержимого преимущества, где нынешний лидер в мощном ИИ может увеличивать своё лидерство и его может быть трудно догнать. Мы должны убедиться, что не авторитарная страна первой достигнет этого цикла.

Более того, даже если баланс сил достижим, всё ещё есть риск, что мир будет разделён на автократические сферы, как в "1984". Даже если несколько конкурирующих держав будут иметь свои мощные ИИ-модели и ни одна не сможет одолеть другие, каждая всё ещё могла бы внутренне подавлять собственное население и её было бы очень трудно свергнуть (поскольку население не имеет мощного ИИ для самозащиты). Таким образом, важно предотвратить ИИ-автократию, даже если она не ведёт к захвату мира одной страной.

Защитные меры

Как защититься от этого широкого спектра автократических инструментов и потенциальных угроз? Как и в предыдущих разделах, я вижу несколько направлений.

Во-первых, мы абсолютно не должны продавать чипы, оборудование для производства чипов или дата-центры КПК. Чипы и оборудование для их производства — единственное крупнейшее узкое место для мощного ИИ, и их блокировка — простая, но крайне эффективная мера, возможно, самое важное единичное действие, которое мы можем предпринять. Нет смысла продавать КПК инструменты для построения ИИ-тоталитарного государства и возможного военного завоевания нас. Выдвигается ряд сложных аргументов в оправдание таких продаж, например, идея, что "распространение нашего технологического стека по миру" позволяет "Америке победить" в какой-то общей, неопределённой экономической битве. На мой взгляд, это как продавать ядерное оружие Северной Корее и затем хвастаться, что корпуса ракет сделаны Boeing, так что США "побеждают". Китай отстаёт от США на несколько лет в способности производить передовые чипы в количестве, и критический период для построения страны гениев в дата-центре, очень вероятно, придётся на эти несколько лет. Нет причин давать огромный толчок их ИИ-индустрии в этот критический период.

Во-вторых, имеет смысл использовать ИИ для усиления демократий в противостоянии автократиям. Вот почему Anthropic считает важным предоставлять ИИ разведывательным и оборонным сообществам США и их демократических союзников. Защита демократий, находящихся под атакой, таких как Украина и (через кибератаки) Тайвань, кажется особенно приоритетной, как и наделение демократий возможностью использовать свои разведывательные службы для подрыва и ослабления автократий изнутри. На каком-то уровне единственный способ ответить на автократические угрозы — превзойти их военным путём. Коалиция США и их демократических союзников, если бы она достигла преобладания в мощном ИИ, была бы в состоянии не только защититься от автократий, но сдерживать их и ограничивать их ИИ-тоталитарные злоупотребления.

В-третьих, нужно провести жёсткую черту против злоупотреблений ИИ внутри демократий. Должны быть пределы того, что мы позволяем нашим правительствам делать с ИИ, чтобы они не захватили власть и не подавляли собственный народ. Формулировка, к которой я пришёл: мы должны использовать ИИ для национальной обороны всеми способами, кроме тех, которые сделали бы нас более похожими на наших автократических противников.

Где провести черту? В списке в начале этого раздела два пункта — использование ИИ для массовой внутренней слежки и массовой пропаганды — кажутся мне ярко-красными линиями и полностью нелегитимными. Некоторые могут возразить, что ничего делать не нужно (по крайней мере в США), поскольку внутренняя массовая слежка уже незаконна по Четвёртой поправке. Но быстрый прогресс ИИ может создать ситуации, для которых наши существующие правовые рамки плохо приспособлены. Например, вероятно, не было бы неконституционным для правительства США вести масштабную запись всех публичных разговоров (например, того, что люди говорят друг другу на углу улицы), и раньше было бы трудно сортировать такой объём информации, но с ИИ всё это можно транскрибировать, интерпретировать и триангулировать для создания картины настроений и лояльности многих или большинства граждан. Я бы поддержал законодательство о гражданских свободах (или, может быть, даже конституционную поправку), которое наложит более строгие ограничения на злоупотребления с использованием ИИ.

Два других пункта — полностью автономное оружие и ИИ для стратегического принятия решений — более сложные границы, поскольку они имеют легитимное применение в защите демократии, но при этом склонны к злоупотреблениям. Здесь я думаю, что оправдана крайняя осторожность и контроль в сочетании с защитными механизмами против злоупотреблений. Мой главный страх — слишком малое число "пальцев на кнопке", так что один человек или горстка людей могли бы по сути управлять армией дронов без необходимости сотрудничества других людей для выполнения своих приказов. По мере того как ИИ-системы становятся мощнее, нам может понадобиться более прямой и непосредственный контроль для предотвращения злоупотреблений, возможно, с участием ветвей власти помимо исполнительной. Я думаю, мы должны подходить к полностью автономному оружию в особенности с большой осторожностью и не бросаться в его использование без надлежащих защитных механизмов.

В-четвёртых, проведя жёсткую черту против злоупотреблений ИИ в демократиях, мы должны использовать этот прецедент для создания международного табу на худшие злоупотребления мощным ИИ. Я признаю, что нынешние политические ветры повернулись против международного сотрудничества и международных норм, но это случай, где они нам остро нужны. Мир должен понять тёмный потенциал мощного ИИ в руках автократов и признать, что определённые способы использования ИИ равносильны попытке навсегда украсть свободу людей и установить тоталитарное государство, из которого нельзя сбежать. Я бы даже утверждал, что в некоторых случаях масштабную слежку с мощным ИИ, массовую пропаганду с мощным ИИ и определённые виды наступательного использования полностью автономного оружия следует считать преступлениями против человечности. Более широко — крайне нужна устойчивая норма против ИИ-тоталитаризма и всех его инструментов.

Возможна ещё более сильная версия этой позиции: поскольку возможности ИИ-тоталитаризма столь мрачны, автократия просто не является формой правления, которую люди могут принять в эпоху после мощного ИИ. Подобно тому как феодализм стал неработоспособен с промышленной революцией, эпоха ИИ могла бы неизбежно и логически привести к выводу, что демократия (и, будем надеяться, демократия, улучшенная и обновлённая с помощью ИИ, как я обсуждаю в "Машинах милосердия") — единственная жизнеспособная форма правления, если у человечества должно быть хорошее будущее.

В-пятых и наконец, за ИИ-компаниями нужно внимательно следить, как и за их связью с правительством, которая необходима, но должна иметь пределы и границы. Сам объём возможностей, воплощённых в мощном ИИ, таков, что обычное корпоративное управление — которое призвано защищать акционеров и предотвращать обычные злоупотребления вроде мошенничества — вряд ли справится с задачей управления ИИ-компаниями. Также может быть ценным, если компании публично обязуются (возможно, даже как часть корпоративного управления) не предпринимать определённых действий, таких как частное строительство или накопление военной техники, использование больших объёмов вычислительных ресурсов отдельными людьми неподотчётным образом или использование своих ИИ-продуктов как пропаганды для манипулирования общественным мнением в свою пользу.